- Автор Lynn Donovan [email protected].

- Public 2023-12-15 23:50.

- Акыркы өзгөртүү 2025-01-22 17:31.

Python менен веб кыргычты колдонуу менен маалыматтарды алуу үчүн, сиз бул негизги кадамдарды аткарышыңыз керек:

- Кыргыңыз келген URL дарегин табыңыз.

- Баракты текшерүү.

- табыңыз маалыматтар сиз чыгаргыңыз келет.

- Кодду жаз.

- Кодду иштетиңиз жана аны чыгарып алыңыз маалыматтар .

- сактаңыз маалыматтар керектүү форматта.

Ушуну эске алып, Pythonдо веб кыргыч деген эмне?

Web Scraping колдонуу Python . Веб кыргыч чоң көлөмдөгү маалыматтарды алуу жана иштетүү үчүн программаны же алгоритмди колдонууну сүрөттөө үчүн колдонулган термин. веб . Сиз маалымат таануучу, инженер же чоң көлөмдөгү маалымат топтомун талдоочу адамсызбы, кыруу алынган маалыматтар веб ээ болуу үчүн пайдалуу жөндөм болуп саналат

Мындан тышкары, Excel веб-сайттан маалыматтарды ала алабы? сен болот таблицасын оңой импорттоо веб-баракчасынан алынган маалыматтар ичине Excel , жана таблицаны түз эфир менен үзгүлтүксүз жаңыртыңыз маалыматтар . Иш барагын ачыңыз Excel . From Маалыматтар менюдан Тышкы импортту тандаңыз Маалыматтар же Тышкы алуу Маалыматтар . киргизиңиз URL ныкы веб баракча сиз импорттоону каалайсыз маалыматтар жана Өтүү дегенди басыңыз.

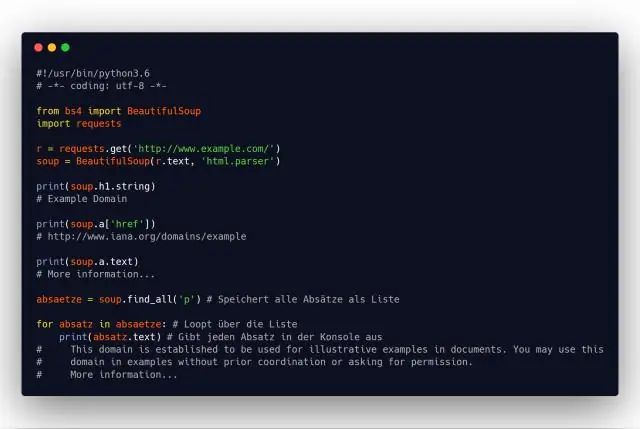

Буга байланыштуу, Python жана BeautifulSoup менен веб-сайтты кантип кырып салсаңыз болот?

Биринчиден, биз колдоно турган бардык китепканаларды импорттообуз керек. Андан кийин, барактын url үчүн өзгөрмө жарыялаңыз. Андан кийин, колдонуңуз Python urllib2 жарыяланган url HTML барагын алуу үчүн. Акырында, баракты талдоо BeautifulSoup биз колдоно турган формат BeautifulSoup анын үстүндө иштөө.

Вебсайттын маалыматтарын кыруу мыйзамдуубу?

Көбүнчө, веб-сайттар үчүнчү тарапка уруксат берет кыруу . Мисалы, көпчүлүк веб-сайттар аларды индекстөө үчүн Google'га ачык же кыйыр түрдө уруксат бериңиз веб барактар. Бирок кыруу бардык жерде бар, ал так эмес мыйзамдуу . Уруксатсызга ар кандай мыйзамдар колдонулушу мүмкүн кыруу , анын ичинде келишим, автордук укук жана кыймылсыз мүлккө кол салуу.

Сунушталууда:

Ansible кандай фактыларды чогултат?

Ансиблде чогултулган фактылар, Фактылар биз алыскы система менен сүйлөшүүдөн алынган маалыматтан башка эч нерсе эмес. Ansible бул маалыматты автоматтык түрдө табуу үчүн орнотуу модулун колдонот. Кээде бул маалымат окуу китебинде талап кылынат, анткени бул алыскы системалардан алынган динамикалык маалымат

Веб скрепинг менен веб скрепингтин ортосунда кандай айырма бар?

Crawling, адатта, чоң маалыматтар топтомдору менен иштөөнү билдирет, анда сиз веб-баракчалардын эң тереңине чейин сойлогон өзүңүздүн жөрмөлөгүчтөрүңүздү (же ботторду) иштеп чыгасыз. Башка жагынан алганда, маалымат скрепинг ар кандай булактан (желеден эмес) маалыматты алууну билдирет

Веб-серверлерден веб-баракчаларды өткөрүү үчүн Интернетте кайсы протоколдор колдонулат?

HyperText Transfer Protocol (HTTP) веб-серверлер жана браузерлер тарабынан интернет аркылуу веб баракчаларды өткөрүү үчүн колдонулат

Эмне үчүн тилкеге багытталган маалымат сактагычы сапка багытталган маалыматтарды сактоого караганда дисктердеги маалыматтарды тезирээк камсыздайт?

Мамычага багытталган маалымат базалары (мамычалык маалымат базалары) аналитикалык жүктөм үчүн көбүрөөк ылайыктуу, анткени берилиштердин форматы (мамыча форматы) суроо-талаптарды тезирээк иштетүүгө шарт түзөт - сканерлөө, топтоо ж.б. мамычалар) жанаша

GC питон эмнени чогултат?

Gc – Таштанды жыйноочу. gc автоматтык таштанды жыйноочу Python'дун эс тутумун башкаруу механизмин ачып берет. Модуль коллектордун иштешин көзөмөлдөө жана системага белгилүү объекттерди текшерүү үчүн функцияларды камтыйт, же чогултууну күтүүдө же маалымдама циклдеринде тыгылып, бошотууга мүмкүн эмес